MUSA (MUltimodal Speech Acquisition)

Le plateau technique MUSA est installé sur le site Stendhal du GIPSA-lab.

Le responsable technique de MUSA est Coriandre Vilain. Christophe Savariaux est le responsable technique adjoint en charge de l'acquisition des données articulatoires (EMA).

Ce plateau permet l'enregistrement de données de production de parole multimodales in vivo dans les conditions acoustiques optimales d'une chambre semi-anéchoïque de 15 m2. Il est utilisé par les équipes du Pôle Parole et Cognition mais également dans le cadre de collaborations du département avec des laboratoires français et étrangers (LPNC, LPP, Univ. Pompeu Fabra de Barcelone, Université de Hanoï,...).

Description

Le plateau MUSA comporte une série de matériel d'acquisition permettant de mesurer et d'analyser les signaux de production de parole :

- deux systèmes EGG (Electo GlottoGraphe) permettant l'enregistrement du mouvement d'ouverture et de fermeture des cordes vocales : un système Laryngogaph et un système EG2-standard développé par la société Glottal Enterprises.

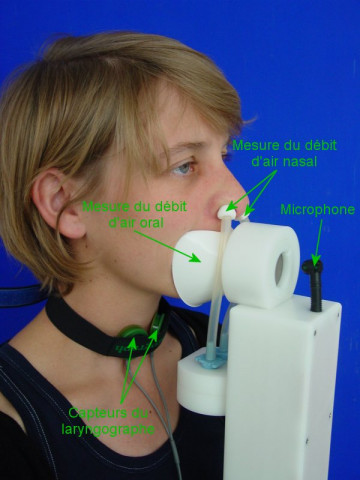

- un système de mesures aérodynamiques Europec-EVA2 développé par le laboratoire LPL permettant l'acquisition synchrone des débits d'air oral et nasal, de la pression intra orale, de l'audio et de l'EGG. Ce système est couplé à un logiciel de présentation et de gestion de corpus au format HTML.

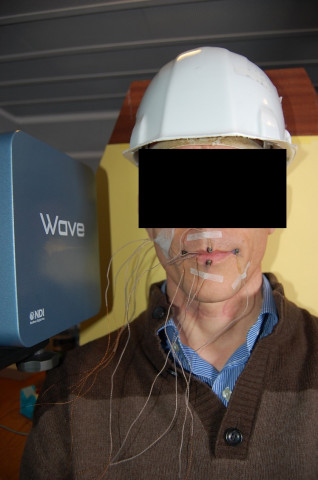

- un système d'articulographie électromagnétique (EMA) permettant la mesure en 3D de la position de petites bobines collées sur les articulateurs de la parole tels que la langue, la mâchoire, les lèvres ou encore le vélum. Le système WAVE développé par la société NDI permet l'acquisition en 3D de 16 canaux à une fréquence maximum de 400 Hz.

- un système d'acquisition aéroacoustique + EGG (D800) développé par la société Laryngograph couplé avec un masque Glottal Entreprise permettant de faire l'acquisition synchronisé des flux oral et nasal ainsi que la mesure des signaux EGG. Ce système est complémentaire du système EVA puisqu' il permet de faire des acquisitions de corpus sur le terrain. Il fonctionne avec le logiciel propriétaire Speech Studio.

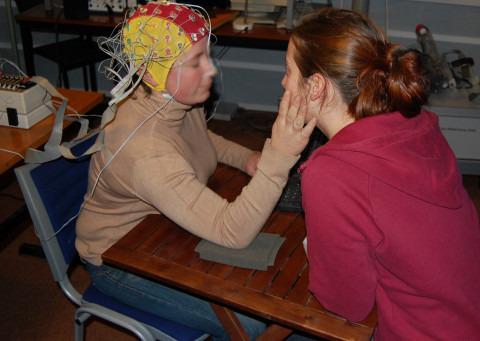

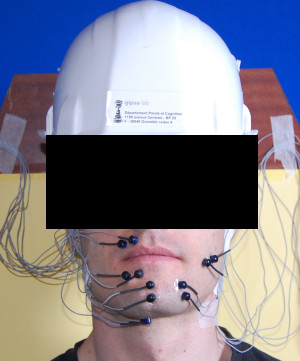

- un système d'acquisition de données EEG BIOSEMI (64 électrodes) permettant de mesurer l'activité électrique du cerveau lors de tâches de perception de parole multimodale.

- un système d'acquisition de données multicanaux (BIOPAC MP150) couplé avec le logiciel d'acquisition AcqKnowledge.

- un ensemble de matériel d'acquisition vidéo HD : deux caméscopes full HD à disque dur HDR-XR500E de Sony ; un caméscope HD à disque dur GZ-HD7 de JVC ; un appareil photo numérique D40 de Nikon.

- un ensemble d'éclairage multi sources en lumière du jour (5200° K) composé de : deux jeux de projecteurs à néons DIVA400 de Kinoflo (4 tubes de 60cm) avec ballast intégré, un projecteur Parabeam400 de Kinoflo utilisé pour l'apport intense de lumière lors de l'utilisation de la vidéo rapide et un kit portable pour un apport ponctuel de lumière (1 tube de 30cm).

- un ensemble de matériel d'acquisition audio : un enregistreur numérique stéréo PMD670 de Marantz ; deux enregistreurs numériques stéréo DR100 de Tascam ; une carte d'acquisition externe FireWire multi pistes Fireface 800 de RME ; une carte d'acquisition externe USB2 multi pistes UltraLite-mk3 de Motu ; une table de mixage 402-VLZ3 de Mackie.

- de nombreux microphones permettant l'acquisition du signal audio pour différents contextes : un micro plaque omni U841E d'Audio-Technica pour l'enregistrement de conversations multi locuteurs autour d'une table ; des micros cravates miniatures omni ATR35S d'Audio-Technica ; un micro-cravate HF EW122-PG3 de Sennheiser ; des micros directionnels C1000S d'AKG pour l'enregistrement en chambre sourde ; un micro serre-tête omni beta-53 de Shure pour l'enregistrement d'un sujet libre de mouvement ; un micro-casque BPHS1 d'Audio-Technica qui permet simultanément l'enregistrement et la restitution au casque.

- un casque fermé HD25-1 de Sennheiser pour faire passer les tests perceptifs dans des conditions optimales.

- un audiomètre Electronica 9910 pour réaliser des audiogrammes des sujets avant de leur faire passer des tests perceptifs.

- un luxmètre ILM1332A de la société Iso-tech pour mesurer la quantité de lumière délivrée.

Ce plateau comprend également un ensemble de logiciels (TRAP, ATAC,...) conçus pour la visualisation et l'analyse des signaux qui en sont issus. Ces logiciels développés sous Matlab, sont disponibles pour la communauté ici.

Exemples d'enregistrements :

Publications récentes associées

- Caron C.J., Vilain C., Schwartz J.L., Leybaert J., Colin C. (2025). Audiovisual Integration in Cued Speech Perception: Impact on Speech Recognition in Quiet and Noise Among Adults With Hearing Loss and Those With Typical Hearing. J Speech Lang Hear Res. 68(8):4158-4176.

- Endo N., Vilain C., Nakazawa K., Ito T. (2025). Somatosensory influence on auditory cortical response of self-generated sound. Neuropsychologia, 211.

- Tran T. T. H., Tusnyingyong S., Vilain C., Sordes P., Gerber S. (2024). Apport des informations audiovisuelles dans la perception et la production de la consonne /v/ par les apprenants thaïlandais du français. SHS Web of Conferences, 2024, 191, pp.09001. ⟨10.3390/brainsci13071036⟩. ⟨hal-04704137⟩

- Jirschik Caron C., Vilain C.E., Schwartz J.L, Bayard C., Calcus Axelle, Leybaert Jacqueline, Colin Cécile (2023). The Effect of Cued-Speech (CS) Perception on Auditory Processing in Typically Hearing (TH) Individuals Who Are Either Naïve or Experienced CS Producers. Brain Sciences, 2023, Special Issue Advances in Understanding the Phenomena and Processing in Audiovisual Speech Perception, 13 (7), pp.10-36.

- Slis A., Savariaux C., Perrier P. & Garnier M. (2022). Rhythmic tapping difficulties in adults who stutter: a deficit in beat perception, motor execution, or sensorimotor integration? Plos Computational Biology.

- Dole M., Vilain C., Haldin C, Baciu M, Cousin E, Lamalle L, Lœvenbruck H, Vilain A, Schwartz JL (2022). Comparing the selectivity of vowel representations in cortical auditory vs. motor areas: A repetition-suppression study. Neuropsychologia. (DOI)

- Paroni A., Henrich Bernardoni N., Savariaux C., Loevenbruck H., Calabrèse P., Pellegrini T., Mouysset S. & Gerber S. (2021). Vocal drum sounds in Human Beatboxing: an acoustic and articulatory exploration using electromagnetic articulography. JASA. (DOI).

- Patri J.F., Ostry D. J., Diard J., Schwartz J.L., Trudeau-Fisette P., Savariaux C. & Perrier P. (2020). Speakers are able to categorize vowels based on tongue somatosensation. PNAS. (DOI).

- Bucci J., Vilain C., Nguyen N., Schwartz J.-L., Dufour D. (2020). Mapping vowel sounds onto phonemic categories in two regional T varieties of French: An ERP study. Journal of Neurolinguistics, 54 (DOI).

- Smith C. L., Erickson D. & Savariaux C. (2019). Articulatory and acoustic correlates of prominence in French: Comparing L1 and L2 speakers. Journal of Phonetics. (DOI).